Индексация — процесс анализа сайта поисковыми роботами. Чем больше требований удовлетворяет контент и домен в целом, тем лучше к нему относятся поисковики. К рассмотрению предлагаются 8 причин, почему сайт не индексируется в Гугле.

Где посмотреть количество проиндексированных страниц?

Перед решением проблемы нужно оценить её масштаб. Основные способы узнать, сколько страниц проиндексировано:

- Использовать оператор «site:».

- Обратиться к онлайн-сервисам.

- Установить браузерные плагины.

- Скачать программу на ПК.

Самый быстрый способ — ввести в поисковую строку «site:адрес_сайта». Так можно увидеть приблизительный результат. Это примитивный метод, следующие решения предлагают не только точную статистику по страницам, но и рекомендации по устранению проблем.

Если сайт не индексируется в Google, время заглянуть в Search Console. Нужный раздел находится во вкладке «Индексирование → Страницы». Там представлен график с проблемными, исключёнными и проиндексированными страницами. За дополнительными отчётами можно обратиться к сторонним сервисам, по типу PR-CY, Raskruty, SeoLik.

Следующий не очевидный, но удобный способ — установить расширение в браузер. Наиболее популярные: RDS Bar, SEO-tools, Seo Magic, Be1. Плагины проводят технический аудит хостинга, указывают на SEO-ошибки, показывают плотность ключевых слов, историю вирусной активности и др.

Инструменты обзора индексации распространяются в виде десктопных программ. Одна из них — Netpeak Checker. За 4 клика софт выведет статус TRUE/FALSE для каждой страницы. Ещё популярна программа Screaming Frog SEO Spider, с её помощью проводят полный анализ и намечают план дальнейшей оптимизации.

8 причин плохой индексации

От опечатки до некачественной вёрстки — рассмотрим решения популярных проблем, блокирующих трафик из Google.

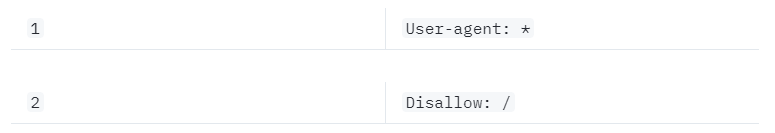

1. Индексация запрещена в robots.txt

От плагинов много пользы, но иногда они делают больше, чем нужно. Модификация robots.txt — неочевидная проблема, с которой сталкиваются, например, пользователи WordPress.

Файл расположен в корневом каталоге, в ответ на запрос возвращает код со статусом 200 ОК. С помощью robots.txt можно запретить индексирование контента: медиафайлов, скриптов, картинок, стилей.

Важно! Содержимое robots.txt — это рекомендации для ботов, которые они могут проигнорировать.

Для решения проблемы нужно отредактировать содержимое файла вручную, исключив из индексации только маловажные страницы. В robots.txt не должно быть косой черты. Если у параметра «Disallow» стоит значение «/», значит блокируются все страницы из корневой папки.

2. Медленный хостинг

Роботы Гугл не любят ждать: если ссылка долго грузится, они перейдут к сканированию следующей. Проблема возникает, когда страница перегружена контентом, или ресурс хостится на устаревшем сервере.

Проверить скорость загрузки можно на PageSpeed Insights. Это онлайн-инструмент от Google для определения фактической производительности сайта. По каждому пункту система выдаст рекомендации, а также обозначит «тяжёлые» элементы страницы. Результат предоставляется в виде диаграммы. Хорошим считается балл в диапазоне от 70 до 90.

3. Бесконечный цикл переадресации

Тот случай, когда опечатка приводит к проблемам с индексацией. Устраняется следующим образом:

- Вставить в поиск Redirect 301, чтобы найти все файлы с перенаправлением.

- Исправить опечатки и прервать бесконечный цикл переадресации.

- Если нашёлся Redirect 302, изменить его на 301.

Программа Screaming Frog поможет выявить другие ошибки. После их устранения рекомендуется повторно подать запрос на индексацию в консоли Гугла.

Важно! Следите за метатегами. По ошибке «noindex», «nofollow» устанавливают на страницах, где этого не требуется. Чтобы открыть ссылку к индексации, нужно удалить приставку «no», оставив «index», «follow».

4. Рендер средствами JavaScript

Скрипты становятся частой причиной, почему Гугл не индексирует сайт. Проблема проявляется на сайтах, использующих крипторы и обфускацию для повышения релевантности контента.

Поисковые роботы умеют распознавать маскировку и относятся к этому негативно. Google не индексирует страницы, на которых вебмастер попытался уникализировать текст программным путём, скрыл файлы JavaScript и CSS.

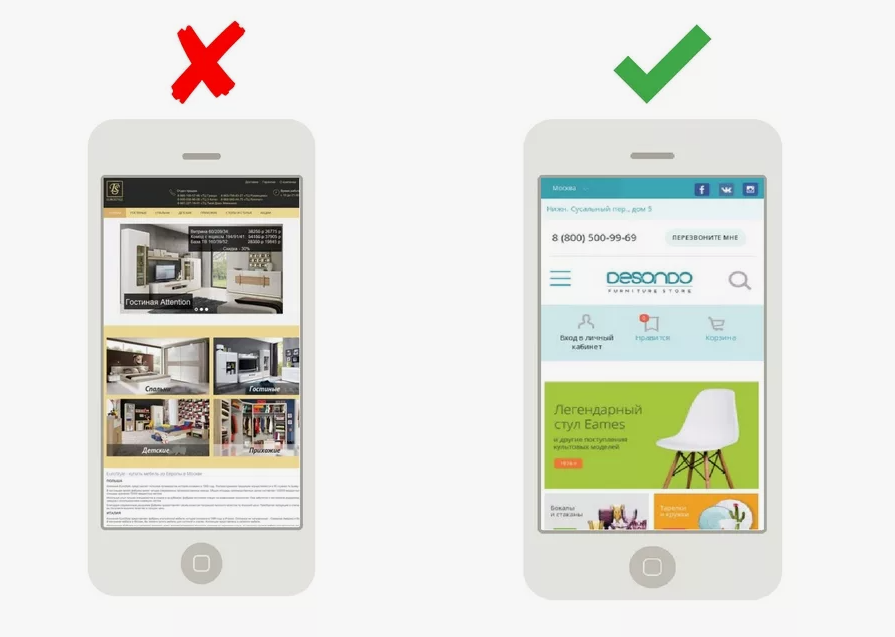

5. Вёрстка не адаптирована под мобильные устройства

С 2015 года у Google в приоритете мобильный индекс: контент считывается именно с мобильной версии сайта.

Есть 3 способа оптимизации вашего сайта под мобильные устройства:

- Выделение поддомена. Мобильная версия реализуется на другом URL с оптимизацией под Android и IOS. Элементы дизайна можно облегчить, чтобы ускорить загрузку страниц. Единственная проблема — затраты на разработку и поддержку поддомена.

- Динамическая подстановка контента. Сервер показывает разные версии сайта пользователям смартфонов, компьютеров и планшетов. Решение не требует отдельного URL. Затраты на разработку и поддержку не меньше, чем на реализацию отдельного поддомена.

- Адаптивный дизайн. Макет сайта будет подстраиваться под размер экрана. Разработка дешевле, URL остаётся прежним, но страдает скорость загрузки. Приходится упрощать функционал, чтобы сайт нормально работал на мобильных устройствах.

Обратите внимание: если динамическая подстановка или адаптивный дизайн уже используется, убедитесь, что страницы корректно отображаются на всех устройствах.

6. «Просканировано» — Google Search Console

Поисковые системы становятся всё более требовательными к содержимому сайтов. Если роботы посетили страницы, но не проиндексировали их, значит проблема в качестве контента.

Чтобы поддерживать уникальную ценность, необходимо:

- Использовать уникальный текст: от заголовков до описаний.

- Не копировать части текста с других источников.

- Объединять повторяющийся контент каноническими тегами.

- Запретить сканирование разделов, не нуждающихся в индексации.

7. «Обнаружено» — Google Search Console

Проблема возникает из-за некачественного контента или проблем со сканированием.

Первая причина, почему Гугл не индексирует страницы сайта, — Googlebot ищет шаблоны в URL. Это происходит, когда нарушена связь категорий со вложенными ссылками.

Вторая причина — лимит сканирования. В очереди много URL-адресов, расходующих краулинговый бюджет. Нужно убрать некачественные страницы из списка на сканирование. Примеры «проблемных» ссылок: результат применения фильтра по категориям, внутренний поиск.

8. «Повтор содержимого» — Google Search Console

Задача алгоритмов поисковиков — предоставлять релевантные ответы без дублей контента. Причиной дублей могут стать:

- Тексты, доступные в переводе на английский язык США, Канады и Великобритании.

- Использование описаний с сайта производителя, которое уже успели скопировать десятки конкурентов.

Важно! Ни один сайт с дублированным контентом не индексируется Гуглом. Чтобы дать пользователю список релевантных ссылок, алгоритмы игнорируют источники неуникальной информации.

Советы по ускорению индексации

Рекомендации от команды SpeedyIndex, чтобы привлечь поисковых роботов Яндекса и Google:

- Не допускайте ошибки 404. Роботы могут не просканировать страницу, потому что в её URL содержится число «404» или в новой копии появились слова «недоступно», «не найдено».

- Пользуйтесь перелинковкой. Страница заслуживает индексации, если она связана внутренними ссылками.

- Оптимизируйте стратегию сканирования. Время анализа страницы ограничено. Чтобы Googlebot не тратил краулинговый бюджет впустую, нужно направлять на индексацию только ценные разделы домена.

- Обновляйте контент. Боты чаще сканируют сайты владельцев, которые следят за актуальностью информации.

- Создайте динамическую Sitemap. Если проект работает на Tilda, то карта сайта динамическая по умолчанию. Для CMS разработаны плагины и отдельные сервисы. Обновленные файлы можно вносить вручную, пометив их тегом <lastmod> до запуска переобхода.

На индексацию уходит от пары часов до нескольких недель. Иногда процесс занимает больше времени из-за нагрузки на Googlebot или медленного сервера.

Чем актуальнее контент для пользователя, тем быстрее Гугл его индексирует. К примеру, ссылки авторитетных источников новостей попадают в индекс через несколько минут.