Исследование BrightEdge доказывает, что поисковики приводят на сайт до 68% трафика. Всего 15% приходится на поисковую рекламу, остальное — органический поиск. Ожидаемо, что внимание пользователей достаётся первым 5–10 ссылкам выдачи. Чтобы попасть в топ и получать до 90% трафика, нужно проверить сайт на индексацию в поисковиках и поработать над его оптимизацией.

Индексация простыми словами

Поисковые системы для ответа на запрос используют индекс — каталог ссылок с ключевыми словами. Алгоритм находит совпадения, составляет и ранжирует список релевантных сайтов — процесс длится доли секунды.

Ссылки для каталога собирают поисковые роботы (краулеры). Они обходят маршрут адресов и выгружают их содержимое. Так начинается индексация — процесс, при котором поисковые системы сканируют, анализируют и сохраняют информацию о веб-страницах.

Алгоритм оценивает источник, анализирует метатеги, контент, вёрстку и многое другое. Проверка проводится для каждой страницы, по её результатам определяется релевантность.

Если алгоритм посчитал ссылку полезной, она попадает в индекс. Данные хранятся в базе и регулярно обновляются. Благодаря индексации пользователь получает ответ мгновенно.

Важно! Время ожидания увеличится до нескольких месяцев, если поисковики будут посылать роботов на сканирование всего интернета при каждом запросе.

После индексации роботы продолжают следить за изменениями. Когда появляются новые ссылки или контент, краулер обновляет информацию в индексе. Этот процесс происходит автоматически и непрерывно.

Проверка индексации сайта через Яндекс Вебмастер

Сервис поисковой оптимизации одинаково полезен для контентных проектов и для интернет-магазинов. Чтобы пользоваться инструментами анализа, нужно выполнить 3 действия:

- Войти в панель Вебмастера.

- Загрузить HTML-файл от Яндекса для подтверждения прав.

- Переместить загруженный файл в корень сайта с помощью FTP-клиента или файлового менеджера на хостинге.

На выбор есть ещё 2 способа: добавить метатега на главную страницу или отредактировать TXT-запись в DNS.

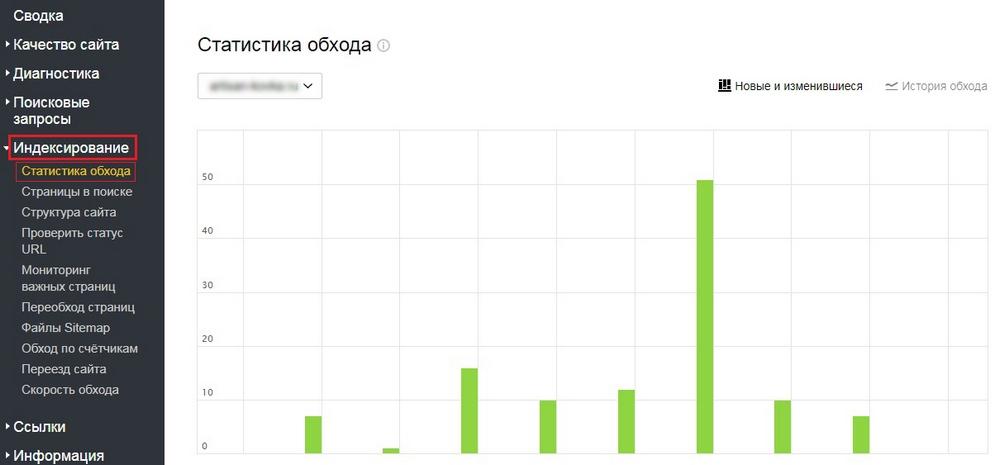

После подтверждения в личном кабинете станет доступна аналитика. Инструменты Вебмастера бесплатные. Сведения об индексации находятся в разделе «Индексирование» — «Статистика обхода».

На графике отображается ИКС — индикатор качества сайта с точки зрения аудитории и Яндекса. Ниже представлены ссылки, а также их статус индексации.

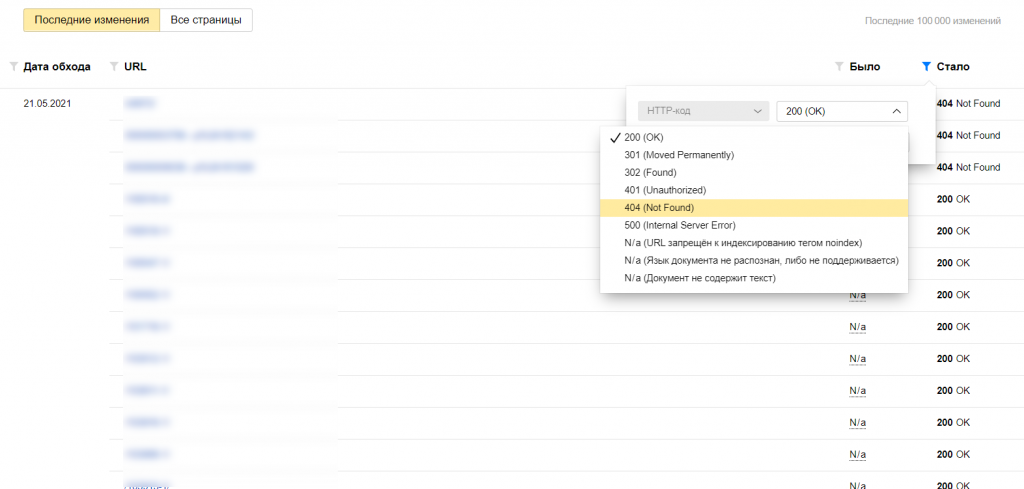

Напротив каждого URL можно видеть коды ошибок:

- 200 ОК — всё в порядке, страница открыта к индексации.

- 500 Internal Server Error — указывает на сбой сервера. Проблема может заключаться в кэше или файлах куки.

- 404 Not Found — страница была удалена. Если она переехала в другое место, нужно настроить переадресацию.

Для проверки индексации страниц необходимо перейти в соседний раздел «Страницы в поиске». Туда попадают URL, которые участвуют в поисковой выдаче Яндекса. Результат можно выгрузить в виде таблицы. Если в строке указан статус «searchable», значит ссылка находится в поиске.

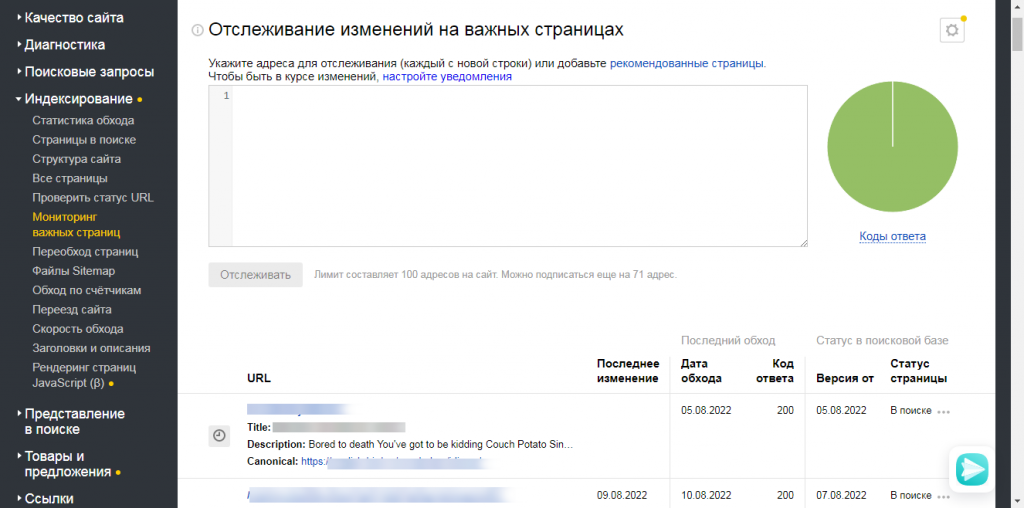

До 100 URL можно вынести в «Мониторинг важных страниц». Опция удобна тем, что отслеживает статус индексации конкретных ссылок. Вебмастер будет оповещать владельца о каждом изменении для этих адресов.

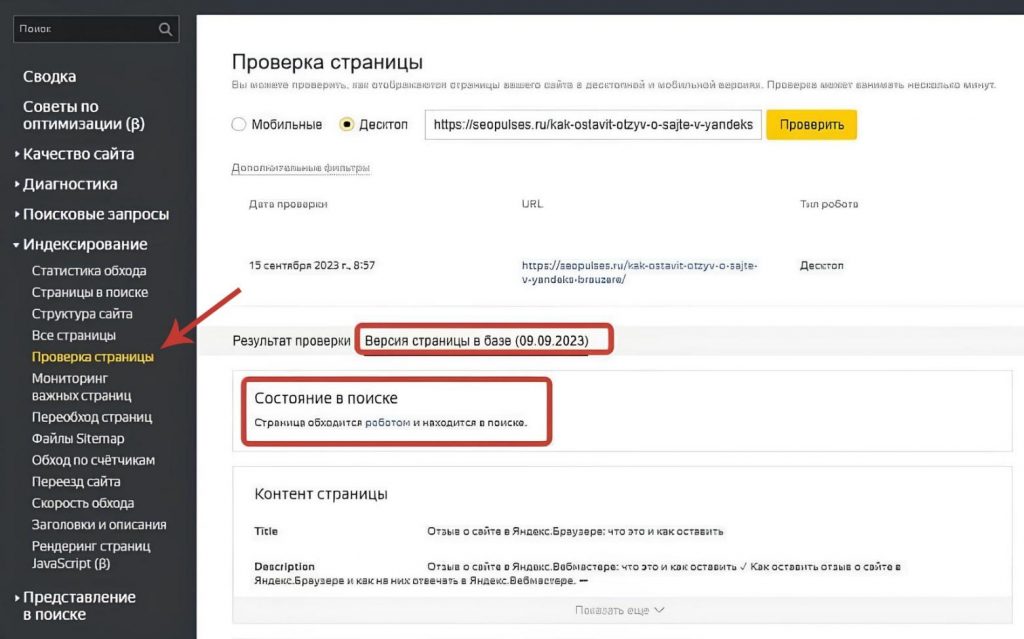

Чтобы узнать индексацию конкретной страницы, необходимо перейти в соответствующую вкладку из раздела «Индексирование». В поле ввода нужно вставить адрес, выбрать десктопную или мобильную версию макета.

Когда сервис выдал результат, переходим во вкладку «Версия страницы в базе». Если всё в порядке, будет надпись «Страница обходится роботом и находится в поиске».

Как проверить сайт на индексацию в Гугле?

Google Search Console — это бесплатный сервис, с помощью которого вебмастера получают информацию о результатах поиска в Google, оптимизируют контент и устраняют неполадки.

Подтвердить права собственности можно несколькими способами:

- Загрузить HTML-файл в корневой каталог.

- Разместить HTML-тег на главной странице.

- По коду отслеживания Google Аналитики.

- По коду Google Менеджер.

- Авторизоваться через Google Site, Blogger или Google Domains.

- Воспользоваться провайдером доменных имён.

В панели Search Console предоставляется информация о том, как Гугл сканирует, индексирует и показывает ссылки в результатах поиска. Это позволяет оптимизировать сайт под требования поисковика.

Важно! Статус индексирования в Яндекс.Вебмастер и Google Search Console может отличаться.

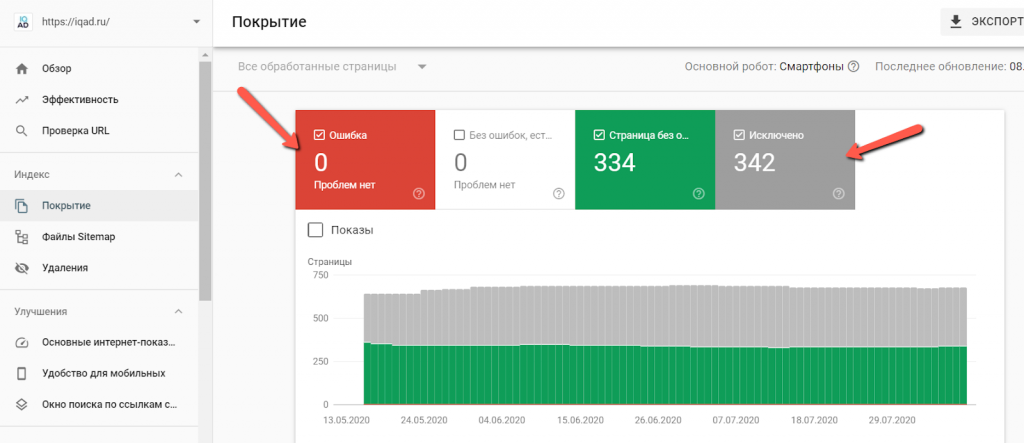

Аналитика по индексации сайта формируется онлайн во вкладке «Покрытие». Там находится график, сортирующий ссылки по 4-ём категориям:

- Ошибка: присваивается странице, если поисковый робот не смог её проиндексировать. Под графиком система обозначит причину отказа и предложит способ её устранения. Проблема возникает, если ссылка была удалена или доступ к ней ограничен.

- Предупреждение: требуют пристального внимания со стороны вебмастера. В жёлтую категорию могли попасть URL, доступ к которым планировалось ограничить через robots.txt.

- Без ошибок: указывает на успешное прохождение индексации. В зелёной категории нет проблемных ссылок.

- Исключено: содержит адреса, которые не попали в индекс. Предполагается, что ссылки относятся к серой категории по указанию вебмастера.

Отсутствие ошибок в красной зоне — признак хорошей оптимизации.

Как проверить индексацию ссылок без доступа к сайту?

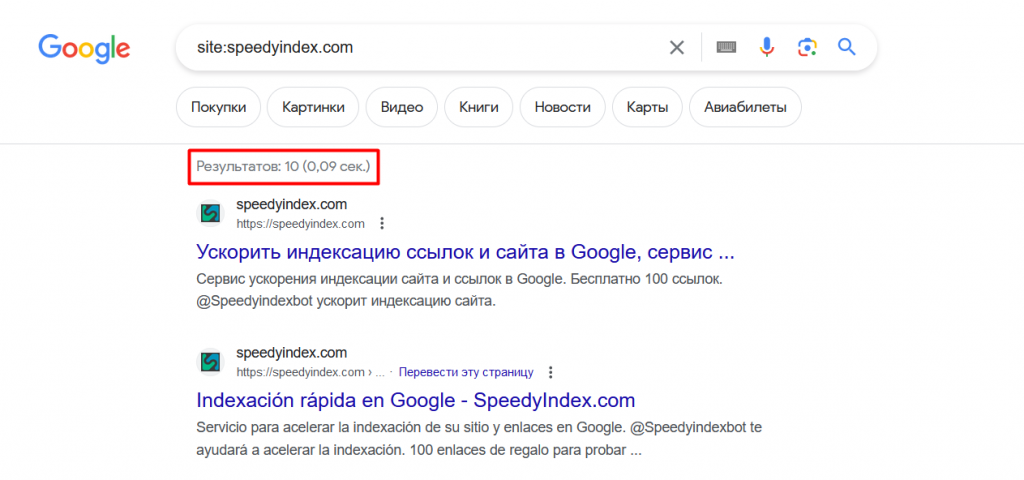

Самый быстрый и простой способ узнать количество проиндексированных страниц — воспользоваться оператором «site».

Недостаток состоит в точности — данные выдачи часто не совпадают с реальностью. Иногда в поиске отображается одно количество ссылок, а в панели Вебмастера или Google Search Console их в 2 раза больше.

Ещё проверить индексирование сайта можно через SEO-сервисы и утилиты. Программы за несколько секунд предоставляют результат сразу по нескольким поисковым системам.

Список бесплатных утилит для онлайн-проверки индексации страниц:

- SEO Magic: дополнение для браузера, чтобы быстро проверить адрес на вхождение в индекс.

- XTOOL: комплексный анализ доверия к сайту со стороны ПС. Агрегирует данные из баз других сервисов — Majestic SEO, Мегаиндекс, Линкпад.

- PR-CY: онлайн-платформа для SEO-мониторинга с ежедневными отчётами и советами по улучшению индексации.

- PIXEL TOOLS: проверят до 36 SEO-параметров. Аналитика содержит фильтры переоптимизации Яндекса, оценку интента, аудит поведенческих факторов и многое другое.

- SBUP: онлайн-сервис комплексной проверки сайта на индексацию. Кроме SEO-информации выводит IP, DNS, движок, скрипты, дату регистрации домена и другие технические параметры.

Важно! Для мониторинга собственного домена рекомендуется ориентироваться на показатели Google Search Console и Яндекс.Вебмастер.

Факторы, влияющие на индексирование

Рассмотрим ошибки, которые выявляет проверка индексации ссылок, их причины и советы по устранению.

Страница недоступна для поисковых ботов

В список проблемных URL иногда попадают ссылки, индексирование которых не требуется. Чтобы краулеры прекратили попытки сканирования, нужно:

- Перейти в файл Sitemap.xml.

- Удалить соответствующий URL-адрес.

Проиндексировать проблемную ссылку сложнее. Страница могла получить отказ по множеству причин:

- Ограничение noindex. Тег принудительно блокирует индексацию конкретной ссылки. Решение простое: удалить noindex из HTML-кода или из заголовка HTTP X-Robots-Tag.

- Ограничение nofollow. Ещё одно значение атрибута «content», запрещающее поисковым ботам посещение страницы. Ограничение указывает на проблемы Google с Javascript, Flash, редиректами, куками или фреймами.

- Ограничение в robots.txt. Содержимое файла краулеры воспринимают как рекомендации. В случае проблем с индексацией сайта в поисковых системах рекомендуется перепроверить robots.txt с помощью инструмента Google.

- Ошибка 404. Страница была удалена или перемещена. Решение: настроить редирект 301 на новую ссылку или восстановить исходный URL.

- Ошибка 404 (soft). Страница существует, но поисковик пометил её недоступной. Причина ошибки в отсутствии контента или редиректах на тематически далёкую ссылку (нерелевантную).

- Ошибка 401. Попытка сканирования не удалась из-за запроса авторизации. Решение: отключить форму входа или разрешить доступ краулеру.

- Ошибка 403. Сервер заблокировал доступ к контенту. Решение: открыть доступ к странице анонимным пользователям и проверить индексацию страниц сайта заново.

- Прочие ошибки переадресации. В индекс не попадают ссылки с длинной связкой редиректов, циклических редиректов или битых URL в цепочке редиректов.

- Ошибка 5xx. Сервер был недоступен во время обхода поисковыми роботами. Если на момент обнаружения ошибки всё в порядке, нужно отправить ссылку на индексацию повторно. Для получения дополнительной информации рекомендуется обратиться к хостер-провайдеру.

Вручную просматривать ссылки по каждому пункту совсем не обязательно. Для этого есть онлайн-сервисы, способные за секунду проверить индексацию страницы и выдать причины отказа.

Качество контента

Содержимое страниц также отражается на результатах индексирования. Не стоит хитрить или рассчитывать на удачу. Алгоритм не пропустит в индекс ссылки:

- с некачественным контентом,

- с дубликатами,

- с фишинговыми формами,

- с вирусами.

Чем чаще на сайте публикуется что-то новое, тем активнее его исследуют поисковики. Если тематика позволяет, заведите блог. Не забывайте запрашивать переобход измененных страниц у роботов Яндекса и Google.

Мобильная версия

Поисковики относительно недавно перешли на Mobile-first — индексирование контента с мобильной версии сайта. Google рекомендует вебмастерам переходить на следующие конфигурации:

- Адаптивный дизайн. Отрисовка контента выполняется в зависимости от размера экрана пользователя.

- Динамический показ. Отрисовка разных версий HTML-кода, используя определение user-agent и HTTP-заголовок.

- Разные URL. Сайт определяет тип устройства пользователя по user-agent и HTTP-заголовку, чтобы перенаправить его на подходящий URL.

Команда разработчиков Google рекомендует использовать адаптивный дизайн, поскольку с ним проще всего работать.

Медленная скорость загрузки

Когда боты заходят на сайт, они уже знают, какое количество страниц можно просканировать за этот день. Этот лимит называется краулинговым бюджетом.

Интересно! Поисковая система ввела такие лимиты, чтобы минимизировать нагрузку на веб-сервер. Краулинговый бюджет исключает ситуацию, когда на сайт с миллионом страниц одновременно зайдёт миллион поисковых роботов.

Медленная скорость загрузки сокращает лимит сессии сканирования. Чтобы увидеть текущие показатели, можно воспользоваться онлайн-сервисом Google PageSpeed Insights.

Перед запуском повторной индексацией страниц онлайн-ресурса команда SpeedyIndex рекомендует:

- Уменьшить задержку за счёт сети доставки контента (CDN).

- Сжать медиаконтент, чтобы ускорить загрузку.

- Удалить ненужные плагины.

- Сократить количество файлов CSS и JavaScript.

Если ничего не помогает, значит провайдер веб-хостинга не справляется с нагрузкой проекта и пришло время его сменить.

Использование HTTP вместо HTTPS

Алгоритмы отдают предпочтение безопасности серверов. Браузеры больше доверяют HTTPS. Устаревший HTTP негативно влияет на ранжирование сайта.

Повысить безопасность сервера можно за счёт получения SSL-сертификата. Соединение между сервером и пользователем будет зашифровано. Нужно избегать просроченных SSL-сертификатов, старых версий протоколов или неправильной регистрации информации о сайте.

Плохая организация Sitemap

Sitemap — инструмент вебмастеров, который помогает краулерам лучше понимать структуру и приоритетность страниц на сайте. Карта формируется в XML-файле и содержит:

- URL-адреса,

- частоту изменений,

- даты последнего обновления,

- приоритет относительно других страниц.

XML-карта предназначена исключительно для поисковых роботов. При грамотном использовании она улучшает позиции в поисковой выдаче.

Для создания и обновления карты сайта удобно использовать бесплатный онлайн-сервис XML Sitemaps. В некоторых CMS (например, в Битрикс) для этого есть встроенный функционал. Сгенерировать карту можно с помощью WP-плагинов: Yoast и All in One SEO.

Полученный файл нужно проверить на ошибки и загрузить в корневой каталог. Отслеживать статус sitemap.xml можно в Google Search Console.

Отсутствие внутренних ссылок

С помощью внутренних ссылок можно выстроить структуру для поисковых систем и удобную навигацию для пользователей вашего сайта. Изолированные страницы ранжируются хуже.

Обратите внимание! Боты эффективнее сканируют контент, если в нём встречается хотя бы одна внутренняя ссылка.

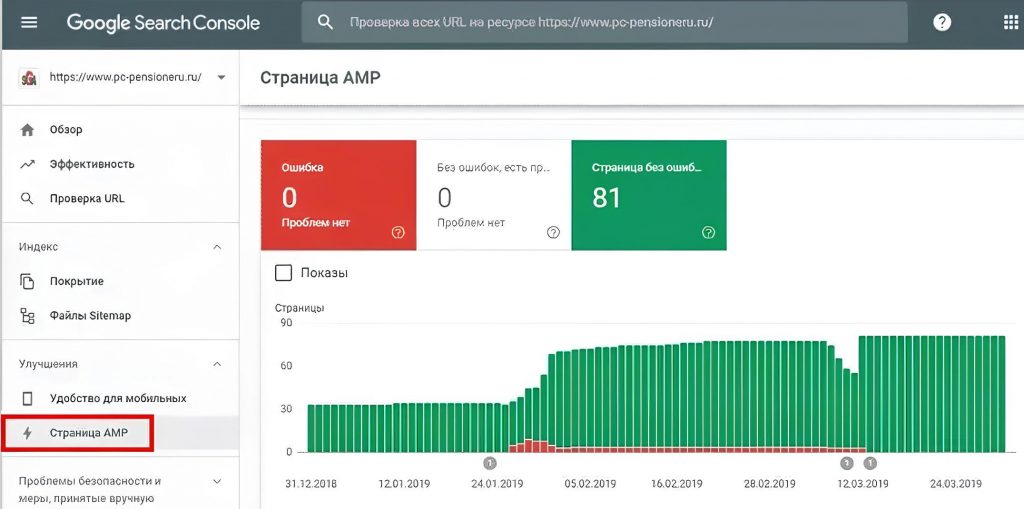

Технология AMP-страниц

В онлайн-панели GSC есть отдельная вкладка для проверки индексации сайтов с облегчённым HTML. Структура отчёта такая же, как для стандартных страниц во вкладке «Покрытие».

Кликнув по строке внизу отчёта, откроются расширенные сведения о конкретной ошибке, а также рекомендуемые способы её устранения.

Ошибки AMP-страниц чаще всего массовые. Консоль выстраивает уведомления в порядке приоритетности, именно в такой последовательности их лучше исправлять. После правок нужно отправить AMP-страницы на переобход и заново проверить индексацию сайта в поисковых системах.

Предупреждения не препятствуют индексированию ускоренной версии URL. Стоит учитывать только то, что АMP-страницам из жёлтой зоны могут быть недоступны опции на выдаче.

Способы ускорения индексации

На сканирование новой страницы может уйти от пары минут до месяца. В интернете есть способы по ускорению индексации, некоторые из них даже работают.

Вручную запрашивать индексирование в GSC

С помощью панели Гугла можно просканировать до 15 ссылок в сутки. Массовую индексацию проводить нельзя. Способ эффективный, но не самый удобный.

Пингование sitemap.xml

Когда на сайте появляется новая публикация, об этом желательно сообщить поисковым системам. Послать «уведомление» можно следующим образом:

- http://www.google.com/ping?sitemap=ссылка_на_ sitemap.xml

- http://www.bing.com/webmaster/ping.aspx?sitemap=ссылка_на_ sitemap.xml

Внимание! Пингование sitemap.xml после каждого обновления контента не гарантирует моментального сканирования.

Редирект 301 со страниц посещаемого источника

Приём позволяет частично перенести статический вес и трафик на другой сайт, которому требуется внимание поисковых ботов. Для этого на сайте с хорошими показателями устанавливается 301 редирект на аналогичную страницу второго сайта. Поисковый робот Google распознает это как перемещение и начнёт индексировать вторую страницу, удаляя первую из индекса. Когда процесс завершится, 301 редирект можно будет убрать.

Повторное добавление сайта

Идея заключается в удалении сайта из GSC и добавлении заново, чтобы привлечь внимание краулеров.

Способ неэффективен — поисковик не воспринимает это как повод для первичной индексации. При повторном добавлении сайт попадает в тот же аккаунт и отображаются старые настройки, в том числе robots.txt.

Трафик из соцсетей

Чем больше пользователей переходит по ссылкам на сайт, тем больший интерес он представляет для поисковых ботов. Хотя алгоритмы на данный момент не учитывают ссылки с социальных сетей при ранжировании страниц, использование этой стратегии помогает ускорить индексацию. «Живые» пользователи стимулируют поисковых ботов заходить на посещаемые страницы чаще.

Внешние ссылки

Google учитывает обратные ссылки с авторитетных сайтов при оценке доверия и важности страницы. Чем больше внешних ссылок ведут на сайт, тем чаще Googlebot будет посещать его для индексации.