Настройка файла robots.txt является одним из ключевых этапов в SEO-оптимизации сайта, особенно в вопросе ускорения индексации. Этот файл используется для управления доступом поисковых роботов к страницам сайта, что позволяет оптимизировать процесс сканирования и индексации. В этой статье мы подробно рассмотрим, как правильно настроить robots.txt для ускорения индексации, а также какие ошибки стоит избегать.

Что такое файл robots.txt?

Файл robots.txt — это текстовый файл, который находится в корневом каталоге сайта и содержит инструкции для поисковых роботов (краулеров). Эти инструкции указывают, какие страницы или разделы сайта могут быть проиндексированы, а какие — нет. Правильная настройка этого файла позволяет управлять поведением поисковых систем на вашем сайте, что важно для эффективного SEO.

Важность правильной настройки robots.txt

Правильная настройка robots.txt способствует ускорению индексации сайта, позволяя поисковым роботам сосредоточиться на действительно важных страницах. Это особенно актуально для больших сайтов с большим количеством страниц. Если файл настроен неправильно, это может привести к нежелательной задержке индексации или даже к полному игнорированию некоторых страниц.

Основные директивы robots.txt

Прежде чем перейти к настройке, важно понять ключевые директивы, которые можно использовать в robots.txt:

- User-agent — указывает, к каким роботам применяются следующие инструкции.

- Disallow — запрещает роботу индексировать определенные страницы или разделы.

- Allow — разрешает индексацию страниц, даже если вышестоящая директива запрещает это.

- Sitemap — указывает на расположение карты сайта, что упрощает роботу поиск страниц для индексации.

Примеры настройки robots.txt для ускорения индексации

1. Оптимизация для поисковых роботов

Самый простой способ ускорить индексацию — это разрешить доступ ко всем важным страницам и запретить неважные или дублирующие страницы. Пример простого и эффективного файла robots.txt:

User-agent: *

Disallow: /admin/

Disallow: /login/

Allow: /public/

Sitemap: https://yourdomain.com/sitemap.xml2. Учет специфики поисковых систем

Каждая поисковая система может иметь свои особенности. Например, для Google можно использовать директиву Crawl-delay, чтобы ограничить частоту запросов от робота, не перегружая сервер. Однако, стоит учитывать, что Google в настоящее время не поддерживает Crawl-delay, но такая директива может быть полезна для других поисковиков, например, Yandex:

User-agent: Yandex

Crawl-delay: 103. Исключение дублирующего контента

Для предотвращения индексации дублирующего контента, такого как страницы пагинации или фильтры, можно добавить следующие директивы:

User-agent: *

Disallow: /*?sort=

Disallow: /*?page=4. Ускорение индексации новых страниц

Для того чтобы ускорить индексацию новых или обновленных страниц, можно добавить ссылку на актуальную карту сайта:

Sitemap: https://yourdomain.com/new_sitemap.xmlЭто позволит роботу быстрее находить и индексировать новые материалы.

Важно: ошибки, которых следует избегать

Ошибки в настройке robots.txt могут серьезно замедлить индексацию сайта. Вот несколько распространенных ошибок:

- Полное блокирование сайта: Порой вебмастеры случайно блокируют весь сайт, используя директиву Disallow: /. Это приводит к тому, что поисковые роботы не могут получить доступ ни к одной странице.

- Блокировка важных разделов: Неправильная настройка может привести к блокировке страниц, которые должны быть проиндексированы, например, страниц продуктов в интернет-магазине.

- Неправильное использование директивы Allow: Если используется директива Disallow: /, важно точно указать, какие страницы должны оставаться доступными с помощью Allow.

- Отсутствие ссылки на карту сайта: Без указания карты сайта поисковым роботам может быть сложно обнаружить все страницы сайта, особенно если они находятся в глубине структуры.

Настройка robots.txt на разных CMS

Настройка robots.txt может отличаться в зависимости от используемой CMS (системы управления контентом). Рассмотрим особенности настройки для некоторых популярных платформ.

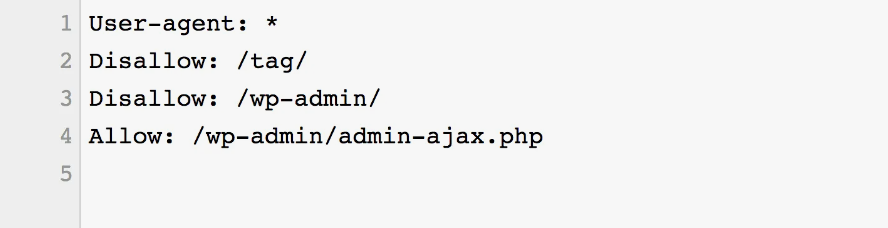

WordPress

Для WordPress рекомендуется разрешать индексацию страниц контента, но блокировать доступ к административной части и служебным страницам:

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Allow: /wp-content/uploads/

Sitemap: https://yourdomain.com/sitemap.xml1C-Битрикс

В 1C-Битрикс важно учитывать специфические разделы и параметры, которые генерируются системой:

User-agent: *

Disallow: /bitrix/

Disallow: /*?sessid=

Allow: /upload/

Sitemap: https://yourdomain.com/sitemap.xmlЗаключение

Правильная настройка robots.txt — это важный шаг в оптимизации сайта, который помогает ускорить индексацию и улучшить видимость сайта в поисковых системах. Настраивая этот файл, важно учитывать структуру сайта, особенности его работы и специфику поисковых систем. Для достижения наилучшего результата рекомендуется периодически проверять файл и вносить в него изменения по мере роста и развития сайта.

Если вы хотите ускорить процесс индексации и обеспечить максимальную видимость вашего сайта в поисковых системах, закажите услугу ускорения индексации на нашем сайте.